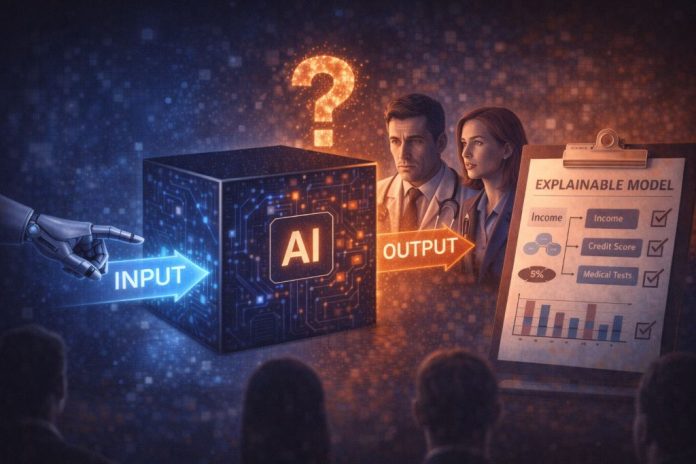

Когда обсуждают безопасность ИИ, часто звучит фраза: «модель ведёт себя как чёрный ящик». Это значит не «магия», а то, что даже разработчики плохо понимают, почему система выдала именно такой результат. В критически важных областях это становится проблемой — поэтому и появляется требование: нужны объяснимые модели.

Что значит «чёрный ящик» в ИИ

Современные нейросети — это миллионы и миллиарды параметров. Мы знаем:

-

как их обучали (данные, алгоритм, метрики);

-

какие ответы модель выдаёт на входы.

Но мы почти не можем прямо прочитать, что «думает» внутри сеть:

нет простого правила вида «если А и Б, то всегда В».

В итоге:

-

сложно понять, какие именно признаки модель считает важными;

-

трудно заметить, что она опирается на случайную или токсичную закономерность;

-

почти невозможно быстро объяснить человеку конкретное решение.

Почему это опасно для безопасности и доверия

Вопросы безопасности ИИ — это не только про «терминаторов», а про очень приземлённые вещи:

-

одобрить или отказать в кредите;

-

пропустить или заблокировать транзакцию;

-

поставить медицинский приоритет пациенту;

-

выдать сигнал «угроза» в системе мониторинга.

Если алгоритм ошибётся или будет систематически предвзят, нужно:

-

понять, что пошло не так;

-

исправить причину, а не просто подправить цифры.

С «чёрным ящиком» это трудно:

-

нельзя убедительно объяснить клиенту или пациенту, почему так решено;

-

сложно доказать отсутствие дискриминации;

-

регулятору трудно проверить, безопасна ли система.

Что значит «объяснимая модель»

Под объяснимостью обычно имеют в виду, что:

-

по конкретному решению можно показать, какие факторы сыграли ключевую роль (например: доход, стаж, результаты анализов);

-

можно увидеть, как модель реагирует на изменения входных данных;

-

есть человечески понятное представление: график, правило, важность признаков.

Иногда для этого:

-

выбирают более простые модели там, где критична проверяемость;

-

«надстраивают» поверх сложной нейросети слой интерпретации;

-

вводят регуляторные требования к отчётности и аудитам.

Говоря, что ИИ — «чёрный ящик», специалисты подчеркивают: мы видим вход и выход, но плохо контролируем внутреннюю логику. В сферах, где от решений зависят деньги, здоровье и безопасность, этого уже недостаточно. Поэтому всё чаще требуют не только точные, но и объяснимые модели — такие, по которым можно задать главный вопрос безопасности: «почему система решила именно так и уверены ли мы, что она не навредит?»